1 – IA, algorithme : de quoi parle-t-on ?

- 28 mars 2020

IA (Intelligence artificielle), algorithme : de quoi parle-t-on ?

1.1 – Les 3 composantes de l’IA

Pour démystifier l’IA, il est utile de revenir à ses éléments de base : l’algorithme, les données, et le calcul statistique. Repartir de ces trois éléments constitutifs permet d’interroger la nature, la place et le rôle que les systèmes IA doivent avoir dans la société et le monde du travail.

algorithme (1) + données (2) + calcul statistique (3) = IA

Questions essentielles au regard de l’introduction des systèmes IA :

Sur l’algorithme : quel paramétrage et quelle certification ? Qu’est-ce qu’on lui demande de faire ? Qui est autorisé à éditer un algorithme ? Qui contrôle sa conformité ?

— L’algorithme est paramétré de façon à pouvoir délivrer les instructions à suivre. Il peut être discriminant dans le cadre de politique RH ou maltraitant vis-à-vis d’un travailleur qui est subordonnée à ses directives. La vigilance est nécessaire pour inciter les acteurs de la chaîne algorithmique, du développeur à l’utilisateur à prendre conscience des enjeux de leur activité. Cela implique une responsabilité et des obligations de certification, de qualification et d’explication au sens humain du terme pour prendre en compte les limites de ces outils dans les choix de programmation ou les critères de classement.

Sur les données : quel volume et quelle qualité des données utilisées pour nourrir et dresser l’algorithme ?

— La qualité du résultat issu de l’algorithme passe en amont par les données. Il est nécessaire de disposer d’une quantité très importante de données fiables, de bonne qualité, sans biais, équilibrées, et pertinentes pour pouvoir nourrir et dresser l’algorithme. S’ajoute la difficulté de l’analyse sémantique de données non structurées. À défaut le résultat issu du traitement statistique sera médiocre et approximatif.

Sur le calcul statistique : quel regard et quelle maîtrise humaine sur le résultat issu du calcul statistique ?

— Le résultat issu du calcul statistique nécessite d’être confronté à l’intelligence humaine pour contrôler et vérifier l’absence d’erreur. Les algorithmes sont écrits par des humains qui peuvent avoir introduit des sources d’erreur dans leur programme. Dans les interactions humain-IA, s’appuyer sur l’IA c’est alors prendre le risque d’une erreur. C’est, par exemple, ce qui s’est produit en mars 2018 avec l’accident mortel causé par une voiture autonome d’Uber en mars 2018. La voiture était programmée pour tenir compte d’un cycliste, d’un piéton, mais pas d’un vélo poussé par un piéton.

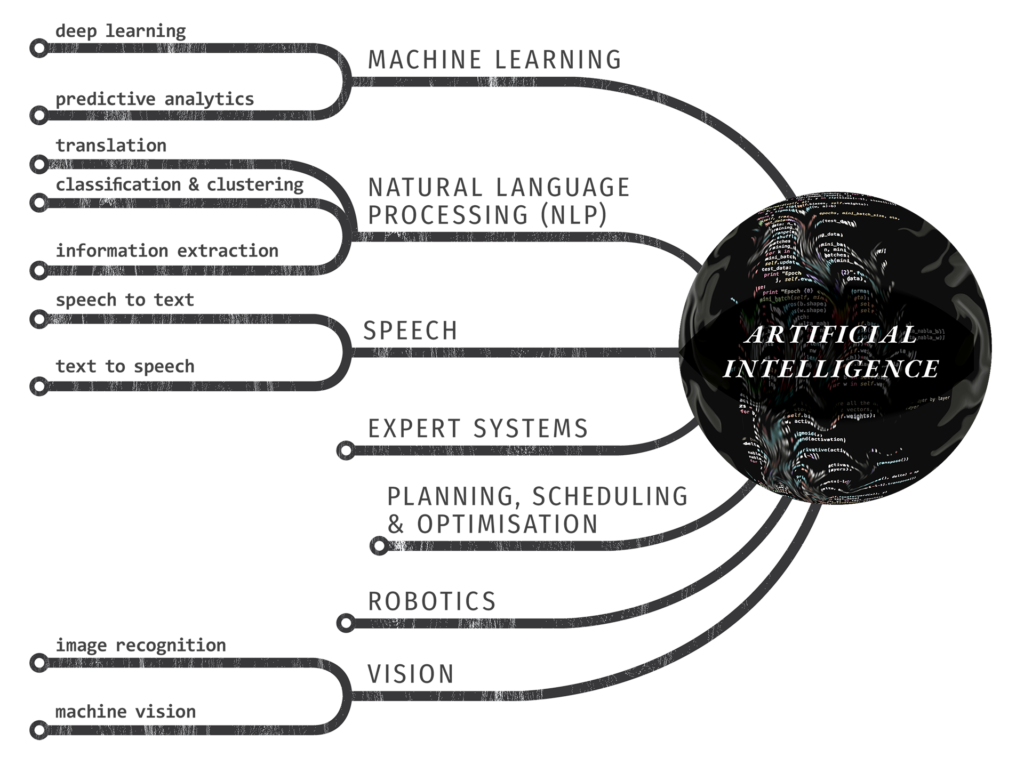

L’arbre de l’IA ci-dessus permet de visualiser toutes ces dimensions qui interviennent de manière structurante dans les dispositifs IA, il serait beaucoup plus judicieux de parler d’informatique avancée. Ce schéma est tiré de l’article Artificial Intelligence in Law The State of Play, écrit par Michael Mills en 2016.

1.2 – Du mythe à la réalité : intelligence artificielle ou apprentissage machine ?

Lorsqu’en mars 2016 le programme AlphaGo de la société DeepMind l’emporte au jeu de Go sur Lee Sedol, un des meilleurs joueurs au monde, la démonstration est faite des progrès en matière d’apprentissage automatique des machines. Cependant, l’efficacité de ces techniques peuvent-elles conclure que les ordinateurs seront en capacité de devenir autonome et de se passer de nous pour agir ? Même douées d’apprentissage et de capacités à faire évoluer leurs propres programmes, les machines restent soumises aux finalités imposées à travers les exemples utilisés dans la phase apprentissage. En configurant l’algorithme d’apprentissage c’est l’humain qui détermine les critères, sans que la machine soit en mesure de les changer.

Dans le champ de la créativité, aucun système IA n’est capable d’élaborer une théorie aussi fracassante que la révolution copernicienne ou la théorie de la relativité. Et dans le champ de la reconnaissance, un enfant de 2 ans qui a vu un chat et l’a caressé une fois n’a pas besoin de dizaines de milliers de photos pour reconnaître un chat. Simuler l’intelligence humaine n’est pas être en capacité de la remplacer.

Les métamorphoses du travail à l’heure numérique se caractérisent comme un « mouvement de mises en tâches (tâcheronnisation) et de mise en données (dataification) des activités productives humaines à l’heure de l’application des solutions d’intelligence artificielle». Ces dernières nécessitent un recours massif au travail humain pour entraîner, encadrer, et fournir les machines en données fiables et utilisables. Si nos interactions avec la machine cessent, le système ne s’enrichit plus et stagne. Quant aux résultats donnés par la machine à l’issu du traitement statistique, l’exemple du pilote d’avion Chesley Sullenberger qui a sauvé tous ses passagers en s’affranchissant des instructions informatiques et en faisant confiance à sa qualité de pilote expérimenté est éclairant.

Après avoir heurté des oies bernaches, privé de ses deux moteurs, il a fait confiance à son expérience et à son instinct de pilote et a réussi à poser son Airbus A320 en catastrophe sur le fleuve Hudson, contre l’avis de toutes les simulations données au même moment par les ordinateurs. L’enquête qui a suivi l’amerrissage dans la baie d’Hudson a démontré qu’il avait choisi la seule solution possible pour sauver ses passagers. Notre cerveau – et le vivant en général – reste plus complexe qu’un ordinateur, et plus pertinent face à l’imprévu. Le risque est donc plutôt de ne plus croire en l’être humain et se reposer sur une machine qu’on laisserait décider et choisir à notre place.

Aujourd’hui, un système IA conscient, capable de penser, et qui supplanterait les humains n’existe que dans l’univers de la science-fiction. Cependant, de réels dangers posés par les systèmes IA existent, comme pour toute technologie, s’il n’y a pas d’encadrement et de contrôle. Les risques de perte d’autonomie et de déresponsabilisation de l’humain dans certains métiers, notamment les plus sensibles (médecins, juges, pilotes ou conducteurs d’engins, DRH), sont réels. Ce sont bien les humains qui doivent assumer l’autorité décisionnelle, même s’ils utilisent des outils et des données pour les y aider. Cela montre que tout système d’IA doit être utilisé comme une aide à l’activité professionnelle ou une aide à la décision toujours sous contrôle et maîtrise humaine, et qu’il ne peut en aucun cas se substituer à l’intelligence humaine.

1.3 – La question fondamentale : quelle finalité donne-t-on à l’IA ?

Le discours marketing sur l’IA contient beaucoup de fables pour détourner notre regard de certains dangers comme : l’exploitation des données des citoyens comme pour les projets « Smart city », la manipulation pour influencer les électeurs comme le scandale Cambridge Analytica en 2018, le management par les chiffres avec les progiciels de gestion intégrées de type ERP, ou l’utilisation de ces nouvelles technologies pour développer le capitalisme de plateforme de type Uber.

Pour l’Ugict-CGT, il s’agit de construire, de sa conception jusqu’à son utilisation, une technologie inclusive, intelligente et sécurisée qui respecte nos libertés citoyennes et notre professionnalisme.

Au premier abord, la « Smart City » promet une meilleure compréhension des usages des habitants et le renouvellement de la gestion des services publics avec de nouvelles solutions de gestion de trafic, de collecte des déchets, une optimisation de la consommation énergétique à tous les niveaux, pour une meilleure préservation de notre planète. Mais derrière cette façade, les expérimentations en cours lèvent des craintes légitimes liées à la privatisation des espaces publics, sur l’omniprésence des capteurs de données dans la ville, et sur l’utilisation qui pourrait en être faites. Place du citoyen (peut-il s’extraire de la collecte de données ?), protection des renseignements personnels, à travers notamment les questions de réglementations et du lieu de stockage et de la propriété des datas centers, et cybersécurité sont de nouveaux sujets sociétaux à traiter sur les villes intelligentes.

Comment garantir dans la société des dispositifs IA inclusifs, sécurisés et de confiance ?

Pour cela il est nécessaire de concevoir une technologie accessible à tous, partout, quel que soit le mode de vie ou le type de foyer, chez soi ou au travail, à la ville comme à la campagne. Elle doit s’adapter à chaque entreprise, chaque collectivité, chaque organisation quels que soient son fonctionnement et ses objectifs. Ensuite, cette technologie doit pouvoir être diffusée à travers des réseaux sécurisés, fiables et qui s’ajustent aux besoins des utilisateurs, à travers des objets attentifs à leur environnement, et sous contrôle des utilisateurs. Enfin, de sa conception à sa mise en fonctionnement, elle doit être conçue à partir d’une démarche éthique avec les utilisateurs finaux, les industriels, commerciaux, institutionnels et académiques ; et intégrer à la fois la sécurité et la confidentialité, et la gestion transparente et sécurisée des données à travers des réseaux fiables et interopérables.

Dans le champ du travail, elle peut apporter une aide dans la complexité de la vie au travail et de son rapport au travail. Cependant, elle représente aussi un risque au regard notamment du paradigme des plateformes qui repose sur l’invisibilité de la relation de subordination. Or, les activités des travailleurs des plateformes produisent de la valeur, sont encadrées d’un point de vue contractuel avec les conditions générales d’utilisation (CGU), sont sujettes à des métriques de performances (followers, scores, likes, etc) et donnent lieu à une para-subordination technique (réponse aux ordres de quelqu’un, alertes, notifications, géolocalisation, etc.). La main libérale évacue les variables sociales de l’innovation technologique pour la faire apparaître comme une phase nécessaire d’un progrès indéfini. Au contraire, situer les dispositifs d’IA à partir du prisme du travail et de celle ou de celui qui réalise l’activité éclaire sur les questions essentielles à se poser. Négocier l’algorithme est fondamental car il fait partie du métier. Les sujets déterminants à traiter vont des conditions d’autorisation et de contrôle des systèmes par rapport à leur finalité, à la réglementation sur l’utilisation des données personnelles, en passant par la responsabilité sociale et sociétale en cas de problème. Enfin, le développement des environnements numériques au travail introduit de nouveaux besoins en formation qui lui sont propres.